Vor lange Zeit hatten ich mal wieder etwas Freiraum, um mich einigen privaten Projekten anzunehmen. Auf dem Plan stand: Die Wayback Maschine von Archive.org anschmeißen und alte Inhalte einer Domain analysieren sowie downloaden. Aber was ist eigentlich Archive.org?

Was ist Archive.org

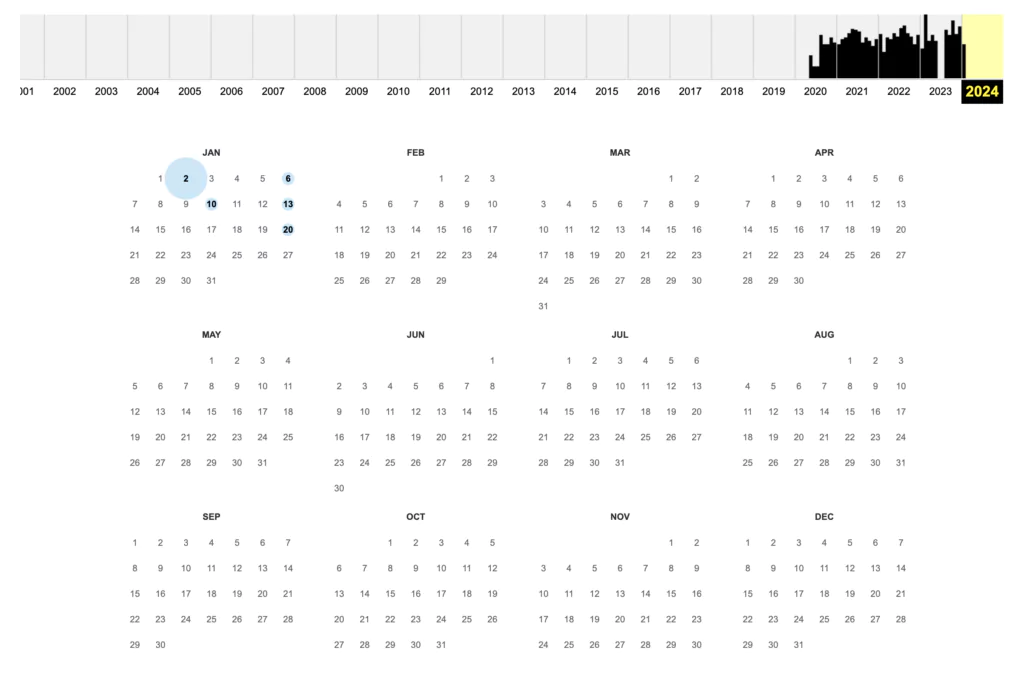

Archive.org ist ein facettenreiches und vielseitiges digitales Archiv, das 1996 von Brewster Kahle in San Francisco ins Leben gerufen wurde. Ursprünglich als „WayBackMachine“ bekannt, dient es der Langzeitarchivierung digitaler Daten und ermöglicht es, die Geschichte des Internets umfassend nachzuvollziehen. Ein wesentlicher Aspekt von archive.org ist die Dokumentation der Historie von Webprojekten. Durch die Speicherung verschiedener Versionen von Webseiten, ursprünglich basierend auf Daten von Alexa Internet, kann man sehen, wie sich Inhalte und Layouts von Domains über die Zeit verändert haben. Interessanterweise sind die archivierten Seiten über https://web.archive.org zugänglich, wobei man durch einfaches Klicken auf eine Jahreszahl in einer grafischen Übersicht zu einer Kalenderansicht gelangt, um das Layout einer Website an einem bestimmten Datum zu sehen.

Nun aber weiter mit dem kleinen Projekt des Downloads..

Überblick verschaffen mit ScreamingFrog

Zuallererst möchte ich wissen, welche und wie viele URLs noch aufgerufen werden können. Dies gibt mir einen ersten groben Überblick auf die Struktur der Website, die Links, Bilder usw.

1) Angabe der kompletten web.archive.org Adresse der Homeseite in ScreamingFrog

2) bei Screamingfrog -> Configuration -> Include -> Eingabe von .*https://deineURL.de/.*

Damit gehen wir sicher, dass er nur innerhalb der URL crawled und nicht andere Webarchive. Beispiel: .*https://www.lightweb-media.de/.*

Download der alten Website

Dazu nehme ich den Wayback Machine Downloader.

Als allererstes Ruby auf dem Mac installieren. Die Anleitung dazu habe ich von hier.

/usr/bin/ruby -e "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/master/install)" brew install ruby echo 'export PATH="/usr/local/opt/ruby/bin:$PATH"' >> ~/.bash_profile source ~/.bash_profile

Jetzt installiere ich den Downloader mit

gem install wayback_machine_downloader

Als nächstes wechsel ich über mein Terminal in mein Downloadverzeichnis (cd Downloads) und gebe den Befehl zum Herunterladen ein.

wayback_machine_downloader https://www.lightweb-media.de

Jetzt suche ich noch eine Möglichkeit, die HTML Files nach dem Download in einem Webspace hochzuladen und voila – die alte Website steht wieder.

Die Kommentare sind geschlossen.