Im folgenden Beitrag möchten wir Dir erklären was in erster Linie eine robots.txt Datei ist, wofür sie verwendet wird und wie sie Dir im Rahmen Deiner Online-Präsenz helfen kann, besser auf Google gefunden zu werden.

Was ist eine robots.txt?

Bei der robots.txt handelt es sich um eine Datei im Stammverzeichnis – der „root“ – der Domain Deiner Website. In der Programmiersprache handelt es sich sogar eher um ein Protokoll als um eine Datei – das sogenannte Robots-Exclusion-Standard Protokoll. In dieser Datei wird festgelegt, wie und in welchem Ausmaß der sogenannte Webcrawler Deine Website durchforsten und lesen darf.

Verwendung von robots.txt

Zu Beginn mag es etwas verwirrend klingen, dass Website-Betreiber den Webcrawler und sein Leseverhalten steuern möchten, ist aber sehr nützlich. Erst dadurch können nämlich Website-Betreiber individuell bestimmen, welche Bereiche ihrer Website für die Suchmaschine gelesen werden dürfen und welche besser gesperrt bleiben. Suchmaschinen gelten oft als sehr penibel und kleinlich, umso wichtiger ist es für Dich als Website-Betreiber Dich richtig vor ihnen zu präsentieren.

Doch Vorsicht: robots.txt ist kein Protokoll zur Geheimhaltung von gewissen Daten, dafür ist immer noch eine HTTP-Authentifizierung von Nöten. Durch das richtige Einbinden der robots.txt Datei kann die Suchmaschine Deine Website schneller und genauer lesen, was folglich zu besseren Ergebnissen im Bereich SEO führt.

Speicherort der robots.txt

Grundsätzlich gibt es nur eine robots.txt je Domain. Jene ist im Stammverzeichnis Deiner Website zu finden. Um auf die Datei zugreifen zu können, musst Du das FTP öffnen und dann auf das sogenannte „public_html“-Verzeichnis gehen. Dort findest Du die Datei außer Du hast noch keine, dann solltest Du Dir eine erstellen.

Bedeutung für SEO

Oft willst Du einfach nicht kritische Inhalte Deiner Seite präsentieren, sei es auch nur einem Bot wie beispielsweise jener von Google. Vor allem große Unternehmen blockieren auf ihren Websites eine Vielzahl von Seiten mit empfindlichen Daten, wie zum Beispiel:

- Verwaltungsseiten (Backend)

- Verzeichnisse

- Kontakt- und Anmeldeformulare

- Seiten mit Kaufvorgängen und Kundenbezogenen Daten.

Und viele mehr… Das folgende Video könnte Dir etwas mehr Auskunft darüber geben, wie bedeutsam die robots.txt Datei für die Suchmaschine und für den Website-Betreiber selbst ist.

Ein weiterer Vorteil der robots.txt Datei ist jener, dass sogenannter „Duplicate Content“ durch das richtige Einsetzen vermieden werden kann. Durch den „Disallow“ Befehl für bestimmte Inhalte, können Suchmaschinen nicht auf den duplizierten Inhalt zugreifen.

Crawler, Index, Backlinks sind für Dich böhmische Dörfer? Du möchtest wissen, wie Deine Chancen stehen Deine Rankings zu optimieren und Deinen organischen Traffic zu boosten?

Kein Problem, wir finden Deinen Platz auf Google.

Wir helfen bei On- und OffPage Analysen, erstellen SEO Audits und führen Deine Website gezielt in die Google Charts.

Erstellen einer robots.txt

Du fragst Dich nun wahrscheinlich, wie Du selbst Deine eigene robots.txt erstellen kannst. Wir helfen Dir gerne dabei. Es handelt sich um ein einfaches Vorgehen, da wie Du bereits erkennen konntest, die robots.txt eine einfache und kurze Textdatei ist. Das Werkzeug, welches Du dafür brauchst, ist ein Texteditor – welchen Texteditor Du wählst, bleibt Dir selbst überlassen. Es ist nur wichtig, dass er die üblichen UTF-8 Textfiles erstellen kann. Ich empfehle Dir den Notepad++ Editor.

- Eine Datei mit robots.txt Befehlen erstellen und „robots.txt“ benennen. Beachte, dass je Domain nur eine robots.txt existieren kann/darf.

- Im „root“ der Domain muss die Datei abgespeichert werden. Wenn Du nicht weißt, wie Du auf das Stammverzeichnis Deiner Domain zugreifen kannst, bitten wir Dich Deinen Webhosting Provider zu fragen.

Fertig, es ist wirklich simpel.

Syntax

Die Syntax der robots.txt ist grundsätzlich sehr einfach. Die folgenden fünf Begriffe solltest Du in Bezug auf die Syntax kennen:

User-agent

Ein Datensatz muss immer mit „User-agent:“ beginnen. Nach dem Doppelpunkt kann aber immer nur eine Angabe geschrieben werden – es kann demnach nur ein bestimmter Bot „XY“ angesprochen werden oder „*“ was so viel bedeutet wie alle Bots. Möchtest Du mehrere spezifische Bots ansprechen, musst Du mehrere Datensätze untereinander schreiben.

- Wenn Du den Bot von Google ansprechen willst, schreibst Du: User-agent: Googlebot.

- Bei dem Bot von Bing analog: User-agent: bingbot.

- Wenn Du alle Suchmaschinen ansprechen möchtest, kannst Du einen Platzhalter wie „*“ verwenden.

Hier nur eine kleine Auflistung der möglichen User-agents.

- Googlebot

- Bingbot

- Slurp

- DuckDuckBot

- Baiduspider

- YandexBot

- facebot

- ia_archiver

Hier eine größere Liste an User-Agents.

Disallow

Wie besprochen werden diese Angaben von den Bots beachtet (nicht) getan zu werden. Hinter dem „Disallow:“ werden nun die einzelnen Pfadangaben geschrieben – diese Seiten soll der Bot letztendlich nicht indizieren. Wichtig hierbei ist, dass nach jedem abgeschlossenen Verzeichnispfad ein abschließender „/“ notiert wird.

Das ist der Befehl für den Bot etwas Bestimmtes nicht zu tun bzw. eine bestimmte Seite Deiner Website nicht zu besuchen, zu crawlen und zu indizieren. Die einzelnen Pfade werden mit einem „/“ getrennt. Falls hier kein Pfad angegeben ist, wird die Anweisung ignoriert und gilt somit als erlaubt.

# Darf nicht ins Verzeichnis /hierKeinGooglebot/ User-agent: Googlebot Disallow: /hierKeinGooglebot/ # Darf die Seite ohne Einschränkungen crawlen User-agent: Google-Image Disallow:

Allow

Damit gibst Du dem Crawler den Befehl die Unterseite einer für ihn beschränkten Elternseite zu lesen. Falls hier kein Pfad angegeben ist, wird die Anweisung ignoriert.

User-agent: Googlebot Allow: /aberHierSchon/

Crawl-Verzögerung

Manche Suchmaschinen sind gerne voreilig mit dem Crawlen Deiner Website. Hierfür gibt es den Befehl „Crawl-delay“, welcher im Datensatz der robots.txt Datei eingefügt wird. Der Befehl „Crawl-delay: 5“ gibt an, dass die Suchmaschine 5 Sekunden warten soll, bevor sie Deine Seite crawlt bzw. erneut crawlen wird.

User-agent: bingbot Allow : / Crawl-delay: 5

Google unterstützt die Crawl-Delay-Richtlinie nicht, sodass ihre Crawler sie einfach ignorieren werden.

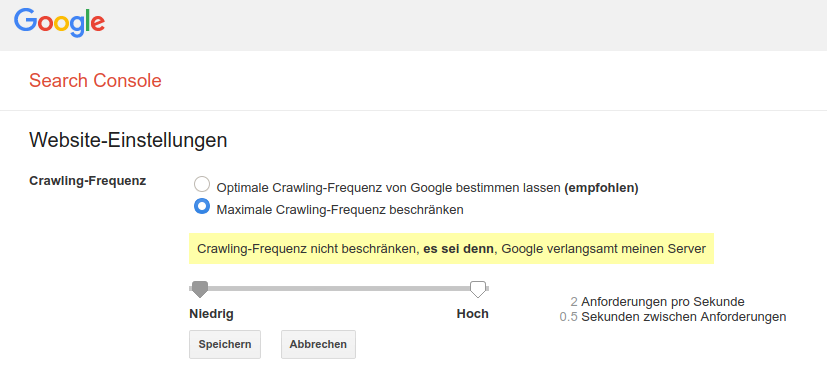

Wenn Du möchtest, dass Google langsamer crawlt, musst Du die Crawl-Frequenz in der alten Google-Search Console festlegen:

Einstellen der Crawl-Rate in GSC

- Melde Dich bei der alten Google-Search Console an.

- Wählen die Website aus, für die die Crawl-Frequenz definiert werden soll.

- Stelle nun die Crawl-Rate, mit einem Schieberegler ein. Standardmäßig ist die Crawl-Rate auf „Optimale Crawling-Frequenz von Google bestimmen lassen (empfohlen)“ eingestellt.

Sitemap

Mit diesem Befehl kannst Du der Suchmaschine mitteilen, wo Deine XML-Sitemap ist.

Zu beachten gilt jedoch, dass nur Google, Ask, Bing und Yahoo diesen Befehl unterstützen.

Sitemap: https://deineWebsite.de/nameDerSitemap.xml

ChatGPT ausschließen

Plugins benutzen den ChatGPT User-Agent, um URLs zu crawlen, z.B. um den Inhalt umzuschreiben. Du kannst das verhindern, indem Du diesen über die robots.txt ausschließt:

User-agent: ChatGPT-User Disallow: / User-agent: GPTBot Disallow: /

Besonderheit CMS

Content Management Systeme sind heutzutage bereits mit vorgefertigten und automatisch erstellten robots.txt Dateien ausgestattet. Das bedeutet, dass Du nicht mehr selbst robots.txt erstellen musst, Du kannst jedoch sehr wohl Deine robots.txt an Deinen Wünschen anpassen. Im Folgenden erklären wir Dir die Anwendung in einigen CMS.

WordPress

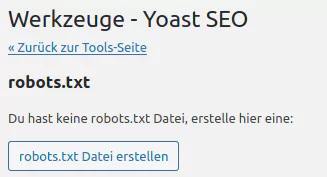

WordPress hat mittlerweile automatisch eine virtuelle robots.txt Datei. Diese kannst Du abrufen, indem Du www.meinewordpressseite.com/robots.txt schreibst. Dann erhältst Du automatisch Deine Datei. Falls Du sie bearbeiten willst, hast Du grundsätzlich mehrere Möglichkeiten:

Mit dem Yoast-SEO Plugin: Zuerst musst Du die erweiterten Funktionen von Yoast SEO aktivieren. Du gehst im Dashboard links auf „SEO“ -> „Werkzeuge“ -> „Dateieditor”.

Oder über /wp-admin/admin.php?page=wpseo_tools&tool=file-editor

Mit dem All-in-One-SEO Plugin: Links im Dashboard auf „Feature Manager“ -> „robots.txt Datei aktivieren“ -> Befehle eingeben.

Per FTP: Du kannst aber auch immer direkt im Stammverzeichnis Deiner Domain eine robots.txt erstellen, so wie oben erklärt.

Die Standard WordPress Robots.txt sollte lauten:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php Sitemap: https://deineDomain.de/sitemaplink.xml

Shopware

Auch in Shopware ist die robots.txt Datei bereits optimiert. Die Robots.txt wird bei Shopware automatisch generiert und als virtuelle Robots.txt bezeichnet. Falls Du die Datei dennoch bearbeiten möchtest, können wir Dir erklären wie.

- Zuerst musst Du auf Deinen Ordner des Templates zugreifen, da die bereits bestehende robots.txt Datei aus diesem Template generiert wird.

- Nun kannst Du die Datei bearbeiten. Am Ende Deines Bearbeitungsvorgangs gehe immer auf Nummer Sicher und überprüfe Dein Ergebnis, indem Du Dir die virtuelle Datei Deiner Website anzeigen lässt.

Typo3

Wie in unseren anderen Systemen, ist auch in Typo3 die robots.txt Datei bereits automatisch erstellt. Aber auch hier kannst Du sie bearbeiten, achte jedoch stets darauf, dass Du sie sauber und vorsichtig bearbeitest. Unter „Site-configuration“ -> „Static Routes“ kannst Du die Datei abrufen und bearbeiten.

Sonstige

Andere CMS wie Joomla, Magento und Jimdo bieten ebenfalls eine automatisch erstellte robots.txt an. Diese kann wie bei den bereits vorgestellten CMS analog im Backend bearbeitet werden.

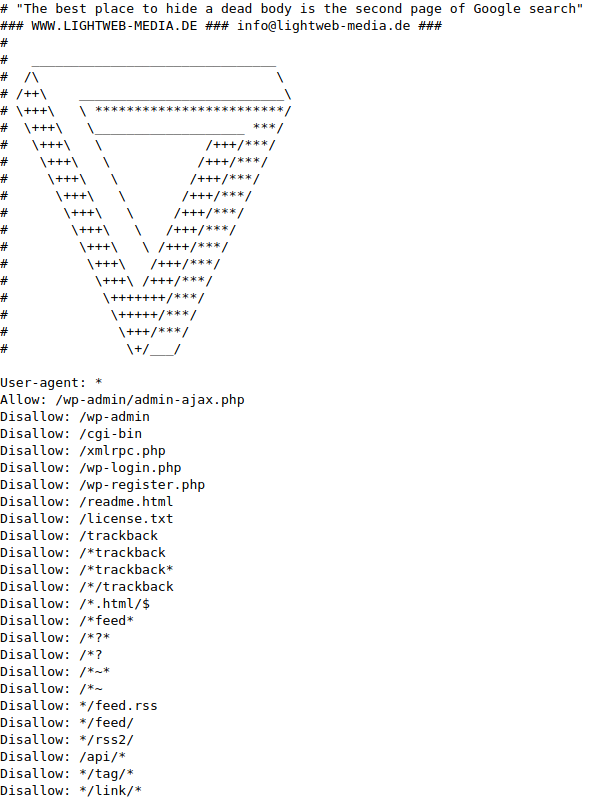

Beispiele für robots.txt

Im Folgenden werden wir Dir ein Beispiel zeigen, wie eine robots.txt Datei aussehen kann. Dabei handelt es sich wie erwähnt um ein Beispiel. Zeilen mit einem „#“ sind Erklärungszeilen für Dich und werden in der tatsächlichen robots.txt Datei ignoriert.

#Suchmaschinen komplett sperren User-agent:* Disallow: / #Nur speziellem Crawler erlauben User-agent: Googlebot Allow: / User-agent: * Disallow: / #Datei sperren: User-agent: * Disallow: /ordner/gesperrte-datei.html #Verzeichnis sperren: User-agent: * Disallow: /gesperrtes-verzeichnis/ #Alle URLs mit beliebigen Parametern sperren User-agent: * Disallow: /*? #Bestimmte Dateien(anhand der Dateiendung) sperren User-agent:* Disallow: /*.mov$

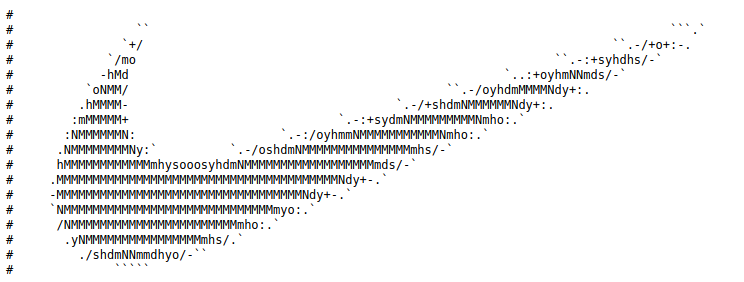

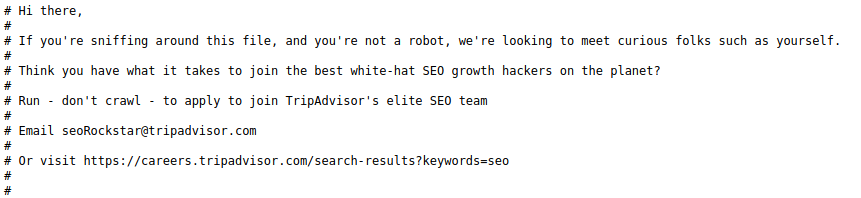

Die Gestaltung der etwas anderen Art

Da wo Code, Text oder Bilder erlaubt sind gibt es auch Menschen (wie mich), die gerne etwas Ausgefallenes darstellen wollen.

Es sind halt nur Zeichen (ASCII) in der Datei erlaubt. Nachfolgend ein paar Beispiele für Kreativität in der Robots.txt.

https://www.nike.com/robots.txt

Humans.txt

Google hat im Jahr 2011 die Datei „humans.txt“ ins Leben gerufen, die Menschen beim Besuch einer Seite Informationen, wie zum Beispiel die namentliche Erwähnung des Programmierers einer Website zur Verfügung stellt. Es handelt sich eher um eine Anerkennung für die Programmierer der Website.

Tools für die robots.txt

Da die Erstellung einer robots.txt Datei für manche Menschen immer noch ein sehr kompliziertes Unterfangen ist, schaffen einige Websites Abhilfe, indem sie sogenannte „robots.txt Generatoren“ entwickelt haben, mit dem Du Dir Deine eigene robots.txt Datei im Baukastenprinzip ganz leicht selbst zusammenstellen kannst. Wenn Du Dich da immer noch nicht zurechtfindest, kann Dir das Webmaster-Tool von Google mit seinem Testtool helfen.

FAQ

In Online-Shops funktioniert das Crawlen von Bildern nicht

User-agent: Googlebot-image

Disallow:

Dadurch gibst Du dem Googlebot die Befugnis Bildern auf Deiner Website zu crawlen.

Die Website wurde trotz Sperre indexiert

–

– Die jeweiligen Seiten in der Google Search Console anhand ihrer URL prüfen und entfernen lassen. „Vorherige Tools und Berichte“ -> „Entfernen“

– Warten bis die URLs entfernt sind und in der robots.txt Datei erneut blockieren.

So stellst Du sicher, dass nur Seiten, die Du indexiert haben willst, auch tatsächlich indexiert sind.

Im Rootverzeichnis liegt keine robots.txt, aber diese ist aufrufbar. Wie kann das sein?

Quellen und weiterer Lesestoff

- A Standard for Robot Exclusion

- Google Support: Einführung zu robots.txt-Dateien

- Google Developers: Robots.txt-Spezifikationen

Crawler, Index, Backlinks sind für Dich böhmische Dörfer? Du möchtest wissen, wie Deine Chancen stehen Deine Rankings zu optimieren und Deinen organischen Traffic zu boosten?

Kein Problem, wir finden Deinen Platz auf Google.

Wir helfen bei On- und OffPage Analysen, erstellen SEO Audits und führen Deine Website gezielt in die Google Charts.