Es ist Sonntag. Ein Kunde schreibt mir sichtlich aufgeregt. 4000 Klicks auf seine Amazonlinks innerhalb von 24 Stunden. Er hat Angst, dass sein Amazonaccount daraufhin gesperrt wird. Auch die Anzeige der Conversion Rate ist dadurch verwässert.

Wie ich ihm geholfen habe, erfährst Du im Detail in diesem Beitrag.

Solltest du das AAWP Login suchen: Hier gehts zu AAWP.

Logfiles Analysieren

Um die Zugriffe nachzuvollziehen, ist der erste Schritt die Analyse der Serverlogs des jeweiligen Webhosters.

Der Kunde hat DSGVO Konform die IPs verschleiert, dass kann man ganz gut an den endenden Nullen in der IP sehen. Ein Eintrag sah z. B. so aus

XXX.XXX.0.0 - - "GET /test-seite HTTP/1.1" 200 30899 "-" "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/85.0.4183.83 Safari/537.36" "Traffic IN:932 OUT:35484" "ReqTime:0 sec"

| Bedeutung | Wert im Beispiel | Erläuterung |

| IP-Adresse | 192.168.0.0 | IP-Adresse des anfordernden Hosts |

| Unbelegt | – | vorgesehen für RFC-1413-Identität, die jedoch standardmäßig (-) nicht ermittelt wird |

| Wer | – | Ggf. Nutzername aus einer HTTP-Authentifizierung, sonst „-“ |

| Wann | Zeitstempel (Datum, Uhrzeit, Zeitverschiebung) | |

| Was | „GET /test-seite HTTP/1.1“ | Anforderung, eines Bildes, Übertragungsprotokoll |

| Ok | 200 | HTTP-Statuscodes (200=Erfolgreiche Anfrage) |

| Wie viel | 30899 | Menge der gesendeten Daten (Byte) |

| Woher | „-„ | Von welcher Internetseite (URI) wird angefordert |

| Womit | „Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/85.0.4183.83 Safari/537.36“ | Mit welchem Webbrowser/Betriebssystem/Oberfläche (UserAgent) |

Gut – zumindest habe ich eine Logfile bekommen und konnte mich jetzt an die eigentliche Analyse machen.

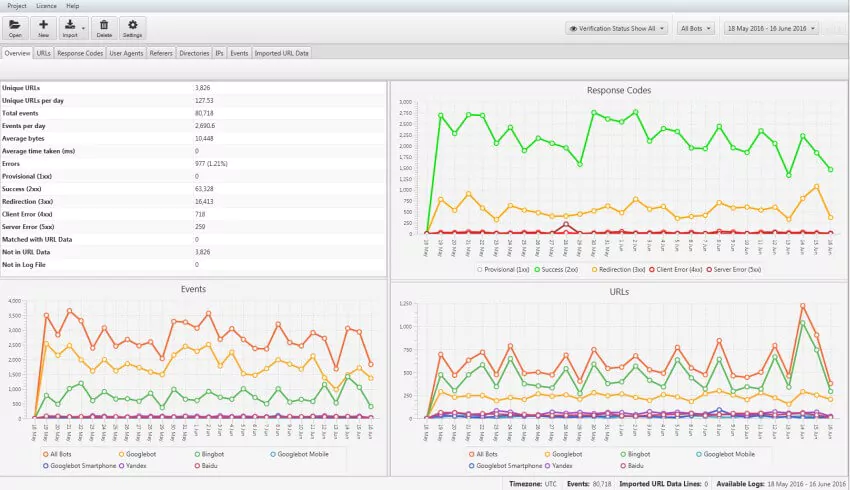

Für Logfiles bis 1000 Zeilen kann man kostenlos den ScreamingFrog Logfile Analyser nutzen, danach kostet es um die 99 Pounds.

Es gibt sicherlich besser oder auch kostenlose Varianten da draußen. Für mich zählt aber Performance/Schnelligkeit und die grafische Verarbeitung der Daten. So konnte ich sehr schnell filtern und den vermeintlichen Verursacher ausfindig machen.

Wir analysieren gerne Deine LogFiles

Bots oder Angreifer aussperren

Zum Aussperren gibt es mehrere Möglichkeiten. Hier muss man genaustens herausfinden wer oder was die Aufrufe auf die Links erzeugt hat.

In unserem Beispiel war es der BingBot, der die Seite mehrfach gecrawled hat. Beim crawlen hat er die Bilder von Amazon / AAWP geladen und somit ein Klick verursacht.

Diesen habe ich einfach per robots.txt für das öffentliche Bild von AAWP gesperrt. Hier mehr über die robots.txt und damit die Steuerung der Crawler erfahren.

User-agent: BingBot Disallow: /wp-content/plugins/aawp/public/*

Solltest Du aber Bots wirklich aussperren wollen, musst Du auf andere Möglichkeiten zugreifen.

Bots mittels IP sperren

Da im o.g. Beispiel kein bösartiger Bot verantwortlich war, musste ich im Serverlog auch nicht die IP Adresse komplett loggen. Da die IP anonymisiert war, ist es schwer, diese zu blocken ohne andere Besucher des Subnetzes mit auszuschließen.

Hast Du die IP, die Du sperren möchtest? Dann blockieren wir mal über die .htaccess. Den folgenden Eintrag an den Anfang der .htaccess setzen und die IPv4 oder IPv6 Adresse natürlich austauschen. Du kannst auch mehrere IP Adressen untereinander setzen.

Order Allow,Deny Allow from all Deny from 123.123.123.123 Deny from 2001:0000:0000:0042

Solltest Du ganze Länder aussperren wollen und WordPress nutzen, kann ich Dir zu dem Plugin Login IP & Country Restriction raten. Hier werden die IP Adressen alle Länder gesammelt und zu 90% richtig erkannt.

Bei Projekten aus dem deutschsprachigen Raum könntest Du z. B. nur die D-A-CH Länder aktivieren – alle anderen bleiben draußen. Aber Achtung – ohne Grund würde ich niemals einfach so IPs sperren.

Bots mittels UserAgent aussperren

Wenn die IP ständig wechselt oder eben nicht bekannt ist, kann man auch UserAgents aussperren. PBN Netzwerke z.b. sperren gerne die Bots von den SEO Tools aus.

Dazu auch wieder in die .htaccess folgenden Eintrag einsetzen und dabei „UserAgentName“ mit dem jeweiligen UserAgent ersetzen.

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} UserAgentName

RewriteRule .* -

Bots bei Nginx blocken

„Nginx Block Bad Bots, Spam Referrer Blocker, Vulnerability Scanners, User-Agents, Malware, Adware, Ransomware, Malicious Sites, with anti-DDOS, WordPress Theme Detector Blocking and Fail2Ban Jail for Repeat Offenders.“ gibts hier.

Fazit

Das Problem mit den Amazon Klicks waren Suchmaschienen. Diese habe ich mittels robots.txt gelenkt.

Solltest Du Probleme mit bestimmten IPs haben, kannst Du diese mittels Plugin oder .htaccess aussperren. Auch gibt es da noch viel mehr Möglichkeiten wie z. B. nur bestimmte Unterverzeichnisse, Weiterleitungen etc., die ich hier nicht behandelt habe.

Auch die UserAgents kannst Du aussperren. Dazu gibt es sicherlich auch genug Plugins. Solltest Du Referrer Spam in Deinen Analysetools haben, kannst Du dies auch per .htaccess oder Plugin verhindern. Aber dazu anderes Mal mehr 🙂

Abschließend rate ich euch zu dem Einsatz einer Firewall. NinjaFirewall wäre hier anzuraten. Näheres zu Firewalls und Absicherung von WordPress erfährst Du hier.

Probleme beim Aussperren von UserAgents?