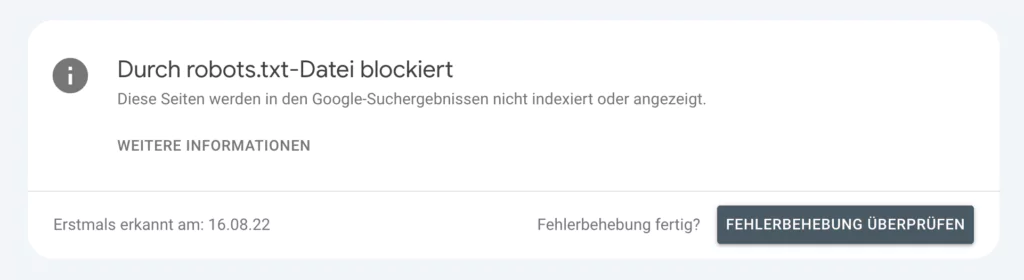

In der Google Search Console (GSC) kann die Meldung „Durch robots.txt-Datei blockiert“ erscheinen. Diese Meldung weist darauf hin, dass bestimmte Seiten Deiner Website durch die robots.txt-Datei für Suchmaschinen gesperrt wurden. Das kann zu Problemen bei der Indexierung und dem Ranking Deiner Seiten führen. In diesem Beitrag erkläre ich Dir, was diese Meldung bedeutet, warum sie wichtig ist und wie Du das Problem beheben kannst.

Was bedeutet „Durch robots.txt-Datei blockiert“?

Die robots.txt-Datei ist eine Textdatei, die Suchmaschinen-Crawlern Anweisungen gibt, welche Seiten oder Verzeichnisse einer Website nicht gecrawlt werden sollen. Wenn eine Seite durch die robots.txt-Datei blockiert wird, kann der Crawler diese Seite nicht besuchen und deren Inhalte nicht indexieren. Das bedeutet, dass diese Seiten nicht in den Suchergebnissen erscheinen können.

Warum ist diese Meldung wichtig?

Diese Meldung ist wichtig, weil sie Dich darauf hinweist, dass einige Seiten Deiner Website möglicherweise nicht indexiert werden, obwohl sie es sollten. Dies kann dazu führen, dass wichtige Inhalte Deiner Website nicht in den Suchmaschinenergebnissen erscheinen, was die Sichtbarkeit und das Ranking Deiner Website negativ beeinflussen kann.

Warum ist diese Meldung oft nicht dramatisch?

In vielen Fällen kann diese Meldung relativ einfach behoben werden, indem die robots.txt-Datei angepasst wird. Es ist jedoch wichtig, regelmäßig zu überprüfen, ob alle wichtigen Seiten korrekt indexiert werden können, um die SEO-Performance Deiner Website zu optimieren.

Im oberen Beispiel möchte ich alle diese Inhalte durch die Robots.txt blockieren und nicht indexieren.

Die erste URL ist ein Affiliate-Link-Cloaking. Die nächste eine Datei nur für Menschen, nicht für Bots. Die PDF braucht es auch nicht im Index und unsere Suchergebnisse ebenfalls nicht. Daher besteht hier kein Problem.

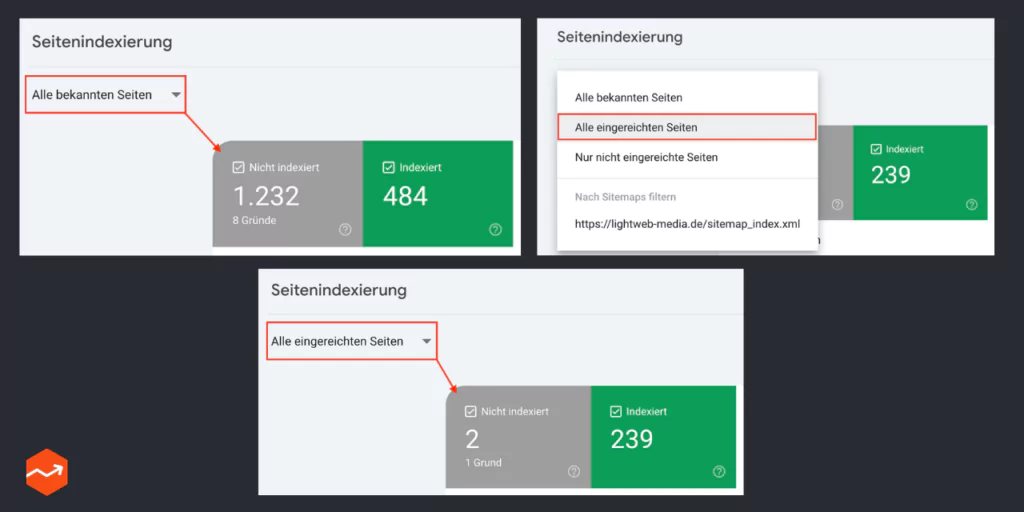

Der Standardbericht „Alle bekannten Seiten“ kann irreführend sein, da er auch viele unwichtige Seiten enthält, die Google absichtlich nicht indexiert.

Um einen klareren Überblick zu erhalten, empfiehlt es sich, eineXML-Sitemap zu Deiner Search Console hinzuzufügen. Danach kannst Du den Bericht „Alle eingereichten Seiten“ auswählen. Dieser Bericht konzentriert sich ausschließlich auf die Seiten in Deiner Sitemap, also jene, die Du tatsächlich indexiert haben möchtest.

Durch diese Vorgehensweise kannst Du gezielt erkennen, welche Deiner relevanten Seiten noch nicht von Google indexiert wurden. Dies ermöglicht Dir eine effektivere Optimierung Deiner Website für Suchmaschinen und verwirrt nicht so sehr.

Wie kannst Du das Problem lösen?

Es gibt mehrere Schritte, um das Problem „Durch robots.txt-Datei blockiert“ zu beheben:

- Überprüfe die robots.txt-Datei:

- Öffne die robots.txt-Datei Deiner Website und prüfe die Anweisungen darin.

- Stelle sicher, dass keine wichtigen Seiten oder Verzeichnisse blockiert werden.

- Entferne unerwünschte Disallow-Anweisungen:

- Falls wichtige Seiten blockiert werden, entferne die entsprechenden Disallow-Anweisungen aus der robots.txt-Datei.

- Nutze geeignete Plugins:

- Bei Websites, die auf Content-Management-Systemen (CMS) wie WordPress laufen, können Plugins wie Yoast SEO oder Rank Math genutzt werden, um die robots.txt-Datei zu bearbeiten und zu überprüfen.

- Für Yoast SEO: Gehe zu „Yoast SEO“ > „Tools“ > „Datei-Editor“.

- Für Rank Math: Gehe zu „Rank Math“ > „Allgemeine Einstellungen“ > „robots.txt bearbeiten“.

- Prüfe auf User-Agent-Blockierungen:

- Stelle sicher, dass keine bestimmten User-Agents (z.B. Googlebot) in der robots.txt-Datei blockiert sind. Das kann ebenfalls dazu führen, dass wichtige Seiten nicht indexiert werden.

- Überprüfe intermittierende Blockierungen:

- Intermittierende Blockierungen können auftreten, wenn z.B. eine Testumgebung und eine Live-Umgebung denselben Cache verwenden. Prüfe den Verlauf Deiner robots.txt-Datei und stelle sicher, dass keine unerwünschten Änderungen vorgenommen wurden.

Beispiel

Unsere Website hat in ihrer robots.txt-Datei folgenden Inhalt:

Disallow: /humans.txt

Hier wird die Datei humans.txt für alle Suchmaschinen-Crawler gesperrt. Wenn dies jedoch eine wichtige Unterseite wäre, würde sie nicht indexiert. In diesem Fall sollte die robots.txt-Datei angepasst werden, um nur unwichtige Verzeichnisse und Dateien zu blockieren.

Mehr zur Robots.txt erfährst Du hier.

Fazit zur Meldung „Durch robots.txt-Datei blockiert“

Die Meldung „Durch robots.txt-Datei blockiert“ in der Google Search Console weist darauf hin, dass bestimmte Seiten Deiner Website für Suchmaschinen gesperrt sind. Durch die Überprüfung und Anpassung der robots.txt-Datei kannst Du sicherstellen, dass alle wichtigen Seiten korrekt indexiert werden und die Sichtbarkeit Deiner Website in den Suchergebnissen verbessert wird. Regelmäßige Überprüfungen und Anpassungen helfen, solche Probleme in Zukunft zu vermeiden und die SEO-Strategie Deiner Website zu optimieren.

Weitere Meldungen erklärt: